Executive summary

A seguito di inchieste condotte dalla magistratura, nei mesi scorsi gli organi di informazione hanno dato ampio risalto al tema dell’antiriciclaggio. Tali inchieste hanno evidenziato aspetti di mala gestio, negligenza nei processi di controllo, inefficienza e, nei casi più gravi, anche la presenza di elementi di dolo nella condotta di alcuni intermediari. Senza entrare nel merito di tali vicende, in questo breve commento si cerca di esaminare come, ancora oggi, l´applicazione concreta di alcuni aspetti della normativa antiriciclaggio non sia affatto semplice, sebbene siano trascorsi diversi anni dalla sua entrata in vigore.

Gli eventi recenti

Come anticipato in premessa, denunce, inchieste della magistratura e sanzioni irrogate dall´Autorità di Vigilanza in merito alla non adeguatezza dei controlli in materia di antiriciclaggio nei confronti di alcuni intermediari hanno avuto vasta rilevanza negli organi d´informazione sia tradizionali che via web. Si pensi ad esempio (i) al risalto mediatico subito dalla succursale italiana di ING Bank[1], successivo alle verifiche ispettive condotte dall´Autorità di Vigilanza e (ii) alle “significative carenze in tutti i comparti rilevanti a fini antiriciclaggio” ed alle “falle nel sistema informatico Gianos[2]” riferibili a Ubi Banca, che sarebbero emerse a seguito di indagini ispettive mirate da parte dell´Autorità di Vigilanza di settore.

Va detto altresì che, negli ultimi anni, generali carenze nell´applicazione della normativa antiriciclaggio e nell´adeguatezza dei controlli in materia di antiriciclaggio hanno dato luogo a sanzioni erogate dalla Banca d´Italia nei confronti di numerosi intermediari, anche di piccole e medie dimensioni.

Appare quindi spontaneo chiedersi come mai vi sia una così frequente e generalizzata non ottemperanza alla normativa antiriciclaggio da parte degli intermediari e se sia veramente cosi, considerata la crescente attenzione posta dalle banche sui temi di compliance che peraltro hanno generato e generano importanti costi. Si tratterebbe dunque di carenze soggettive da trattare caso per caso? O potrebbero ravvisarsi anche difficoltà sistemiche oggettive? Sarebbero quindi possibili margini di miglioramento?

Le operazioni c.d. anomale e la difficoltà della loro individuazione.

Senza alcuna pretesa di riuscire a rispondere esaustivamente a domande così complesse, cerchiamo di partire da alcuni dati statistici pubblicati dalla stessa Autorità di Vigilanza e relativi alle segnalazioni di operazioni sospette (S.o.s.), pervenute dal sistema bancario italiano e non, all´Unità di informazione finanziaria (UIF). Si comprenderà sin da subito che, a livello sistemico, i numeri in questione sono rilevantissimi.

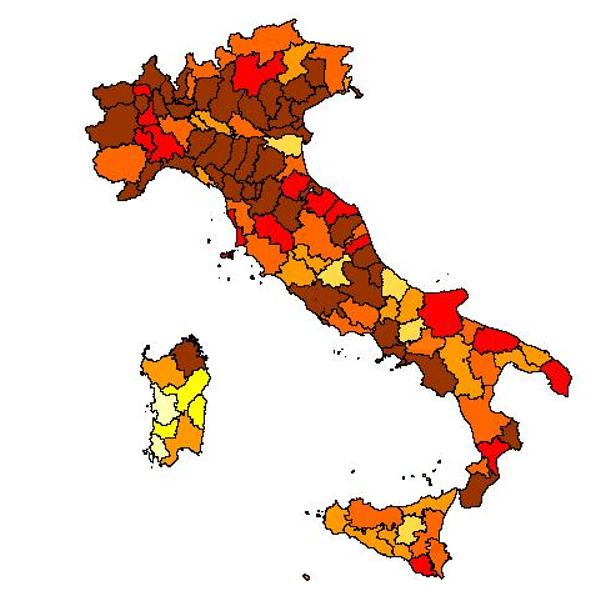

Alcuni dati essenziali. Nel corso del 2017 sono pervenute alla UIF n. 93.217 segnalazioni di operazioni sospette (numeriche che hanno rappresentato un forte trend di crescita rispetto al passato. Si pensi ad esempio che nel 2013 la UIF aveva registrato circa 64.000 segnalazioni). Di queste oltre 93.000 segnalazioni, la UIF ha trasmesso agli Organi investigativi oltre 47.000 evidenze, pari quindi al 51% di quelle ricevute. Di seguito un cartogramma con la densità di segnalazioni, tratto dai quaderni di antiriciclaggio riferiti al 2017 pubblicati da Banca d’Italia.

Proprio di recente, anche con riferimento a queste tematiche, è stato pubblicato un documento dalla Uif intitolato “l’impatto delle ispezioni antiriciclaggio sull’attività di segnalazione di operazioni sospette da parte delle banche: un’analisi empirica del caso italiano”[3] da cui è possibile dedurre alcune considerazioni. Un documento che se da un lato ha rappresentato fatti già noti al sistema bancario, dall´altro ha avuto il pregio di consolidare tali considerazioni estendendone la portata ad un pubblico più vasto. In questa valutazione empirica si rappresenta infatti che (i) le ispezioni inducono un aumento delle segnalazioni di operazioni sospette inviate dalle banche nel trimestre successivo all´ispezione e che (ii) l´impianto normativo antiriciclaggio (principalmente con riferimento alla fonte legislativa di livello primario) porta con sé un´asimmetria del sistema sanzionatorio riferibile al fatto che le sanzioni possono colpire l´eventuale omissione di segnalazione di operazione sospetta ma non l´invio eccessivo di report infondati. Tale circostanza potrebbe favorire, almeno in astratto, una interpretazione da parte delle banche (e dei soggetti obbligati in generale) che porterebbe a sovra segnalare a scopo cautelativo (generando così il c.d. effetto “al lupo al lupo”). Ciò rappresenta chiaramente una minaccia all´efficacia del sistema.

In questa ottica, se da un lato va considerato che la segnalazione di operazione sospetta è di per sé affetta da un margine di discrezionalità del segnalante (che cerca di essere minimizzato anche grazie all´emanazione dei puntuali indicatori e schemi di anomalia dalle Autorità di Vigilanza), dall´altro la questione della segnalazione c.d. a scopo cautelativo ha a che fare con tematiche di alto livello come principi etici, costi aziendali e sociali, insomma le logiche di trade off.

Sempre in tale ambito vanno considerati anche i sistemi di detection delle operazioni anomale di cui deve dotarsi ogni intermediario. Si tratta, in estrema sintesi, di processi strutturati che iniziano con la raccolta e la messa in evidenza di tutte quelle operazioni della clientela che per importo, caratteristiche del cliente, frequenza, controparte, paese della controparte (etc…) possono, almeno in astratto, determinare un rischio potenziale di riciclaggio più elevato[4].

Di fronte a tali evidenze, la Banca (o l´intermediario in generale) è costretta a domandarsi se l´operazione rilevata[5] debba confluire o meno in una segnalazione di operazione sospetta. Ne deriva che anche tali sistemi di detection, a seconda di come essi vengono tarati, possono far parte delle cause per cui il numero delle segnalazioni di operazioni sospette (cautelative o meno) continua a crescere.

Nei processi delle banche e/o nei software da queste utilizzate, sembra riscontrarsi una mera replica della lista degli indicatori di anomalia tradotti in algoritmi statici, senza uno sforzo per un framework globale e robusto.

Ma allora, come fare a generare meno evidenze (siano esse interne all´intermediario e al suo sistema di detection o che sfocino in vere e proprie segnalazioni di operazioni sospette indirizzate alla Uif) e di maggiore qualità?

Per affrontare il problema cerchiamo di fare un parallelismo con quello che ancora oggi é il core business del settore bancario tradizionale: la concessione del credito.

In particolare, se la banca ha un sistema di rating su scala 1 a 10 (con 1 la classe di rating migliore) a quale livello di rating va rifiutata la richiesta di nuova erogazione?Se un cliente ha rating non buono, supponiamo 7, si gestisce il tutto nel pricing (o aumentando le richieste di garanzia), cioè applicando un tasso elevato al prestito, o meglio rifiutare, con il rischio di perdere buoni margini? Certamente, in questo ambito, le risposte dipendono dal risk profile, ma nell´antiriciclaggio, al di là degli aspetti di compliance normativa, c’è un problema in più che appare insormontabile e cioè la difficoltà (o forse l´impossibilità) di condurre un backtesting. Ci spieghiamo meglio:

- Nell’ambito del rischio di credito, ad esempio, il backtesting consiste nel confrontare i rating (e le PD) a 1 anno con i tassi di ingresso in default o in sofferenza dei clienti dopo 1 anno dalla misura del rating. Così facendo si ottiene una verifica ex-post della qualità dei modelli, ed ex-ante i modelli vengono calibrati per la migliore predittività possibile;

- Nell´ambito del rischio di mercato, quando si calcola il VaR di un portafoglio con orizzonte 1 giorno, lo si confronta con le perdite e i profitti di giornata, cioè se le perdite superano la massima perdita espressa dal VaR supponiamo al livello 99%. Ci si aspetta quindi che su una opportuna lunga finestra temporale le perdite siano superiori al VaR con frequenza non troppo lontana da 1%. Come utile esempio, la normativa di Basilea sui rischi di mercato e i modelli interni di misurazione, considera ottimo un modello che su 250 giornate abbia, al più, 4 eventi di perdita maggiore del VaR.

In antiriciclaggio, queste fasi ci sembrano di difficile applicazione. Non c’è né un evento ex-post contro cui effettuare il backtesting, né la possibilità di calibrazione dei modelli. Molto spesso, infatti, l´avvio di indagini da parte della magistratura, l´esecuzione di sequestri o provvedimenti di altro genere, divengono noti all´intermediario solo dopo diverso tempo (senza considerare che si tratta di eventi non così frequenti per cui risulta ancor più difficile affidare alla statistica la costruzione di robusti modelli). Ad esempio, con riferimento ai dati richiamati dalla stessa UIF si riscontrano 661 acquisizioni di SOS su 47.000 nel II semestre 2017 da parte della magistratura. Ciò equivale ad un tasso di circa 1.25% che rappresenta un evento raro, paragonabile al tasso di default. Il problema è che a differenza dell’ambito del credito per ovvie ragioni la banca stessa che dovrebbe calibrare i modelli innestati nei sistemi informatici non sa quali siano questi eventi, se non appunto in casi conclamati pubblici, per cui ogni backtesting, appare, in sostanza, precluso.

Ed allora cosa fanno quindi la maggior parte degli intermediari nelle prassi riscontrate dalla Uif? Un po’ per i rischi sanzionatori e reputazionali a carico degli organi aziendali, dei delegati alla segnalazione di operazioni sospette e dei responsabili di primo livello, si attengono ai talvolta rigidi processi interni, alla mera applicazione dei vari schemi di anomalia, e con una buona dose di prudenza sommergono la Uif di segnalazioni, anche quando palesemente riscontrano un rischio bassissimo o nullo.

Qualità dei software in uso agli intermediari. Big Data & Analytics

Riprendiamo il tema delle “falle” nei sistemi informativi descritti in premessa. Un primo punto da ricordare è che le proprietà che un software dovrebbe soddisfare son ormai ben note, e sono per esempio declinate in modo organico anche in alcuni framework normativi, quali il cosiddetto RDARR, risk data aggregation and risk reporting.

Tra tali auspicate proprietà, si ricorda:

- profilazione, cioè assegnazione di grants ben diversificate agli utenti, in modo che non sia facile, grazie a un meccanismo di contrapposizione di interessi, che via siano “super utenti” fuori controllo;

- auditability, cioè la tracciatura di tutte le attività effettuate sui dati (ad esempio: inserimento, modifica, cancellazione). Questo si ottiene se il sistema consente di gestire i “log” e anche impostarne il livello di dettaglio, (cosiddetta verbosity). Così facendo si può per esempio “versionare” gli stati del dato, cioè memorizzarne tutti i valori assunti (chi lo ha modificato e quando lo ha fatto);

- roll back, cioè potere ripristinare i sistemi a una data passata per potere rieseguire i processi in quella stessa data;

- providing e deproviding, un processo di assegnazione delle utenze e dei profili efficace, e la cessazione delle utenze o modifica a seguito, ad esempio, di cambio di ruolo o di ufficio dell´utente;

- intermediazione nell’accesso ai dati. Si tratta cioè di porre tra l’utente e i dati (tabelle del database) le opportune interfacce e maschere grafiche (dette GUI), così da impedire che si possa con strumenti informatici quali le query accedere direttamente alle tabelle per effettuare modifiche e cancellazioni.

Riguardo agli eventi richiamati nel primo paragrafo, non si può certo dire in questa sede cosa sia avvenuto. Di certo sembra che i sistemi software utilizzati non avessero all’epoca tutte le necessarie proprietà ed è altrettanto vero che in caso di collusioni di un numero alto di soggetti con logiche fraudolente il sistema informatico non può essere resiliente a qualunque manipolazione.

Ma il vero problema è a nostro parere un altro, se pensiamo alle sfide poste dalle attività di antiriciclaggio nell’intercettare potenziali operazioni sospette. All’avvio degli obblighi normativi, il sistema bancario italiano si è adagiato in modo forse eccessivamente rigido su pochi o forse su un solo sistema software quando, al contrario, una più aperta concorrenza avrebbe stimolato una più rapida ed efficace evoluzione degli strumenti. Basti pensare che anche in altri elementi vitali del sistema informativo delle banche italiane, come a puro titolo di esempio i sistemi di position keeping della finanza o i sistemi di predisposizione dei flussi di vigilanza, vi sono almeno 3-4 soluzioni di mercato in forte competizione che determinano miglioramenti continui[6].

Invece un po’ per questo motivo e anche per le ragioni illustrate nella sezione precedente ci si è adagiati sulla mera ripetizione degli schemi di anomalia, trasformati in “warning” del sistema informatico.

A pensarci bene l´AUI (archivio unico informatico), database core dell´antiriciclaggio, è un archivio multidimensionale che contempla numerosissimi dati riferibili alle operazioni, al cliente ed alla sua controparte, al settore di attività della clientela e a quello geografico. Visti nel tempo, si tratta di serie storiche caratterizzate da intensità, frequenza, ecc. per un totale di molte decine di variabili (“campi”). Il flusso AUI di una banca, in pratica, costituisce da solo un esempio di big data nella sua moltiplicazione di casi (operazioni) e variabili.

Ecco, senza mettere in gioco termini abusati quali machine learning e artificial intelligence, riteniamo che la strada corretta possa essere quella di investire in logiche e strumenti di data mining e discovery, cioè strumenti con efficaci funzioni algoritmiche e di visualizzazione che consentono una rapida e più efficace esplorazione dei dati stessi, una costruzione più dinamica e meno spoglia di semafori di warning, nonché una maggiore aggregazione di dati in modo da consentire analisi e ricerca di potenziali fenomeni “nascosti” nei dati.

Sembra che, negli ultimi 3-4 anni, alcune realtà di grandi dimensioni si siano finalmente mosse in questa direzione. Certo serve anche una evoluzione di prospettiva e/o di skills anche nelle funzioni di compliance e antiriciclaggio, spesso abituate a un approccio istruttorio sui singoli casi e meno ad un´analisi massiva dei dati. Questa prospettiva potrebbe, anzi, dovrebbe, coesistere con un approccio orientato all´analisi dei singoli casi. Se ciò mancasse del tutto probabilmente si perderebbe quella parte della visione logico/giuridica dei fenomeni sottostanti e delle finalità a cui tende la normativa.

Si auspica, insomma, che queste due anime analitiche possano coesistere e lavorare sempre più a stretto contatto, poiché ad oggi a giudicare dai numeri pubblicati dalla Uif, il sistema delle segnalazioni sembra migliorabile.

Riferimenti

i) Banca d’Italia (2017), Quaderni dell’antiriciclaggio dell’Unità di Informazione Finanziaria;

ii) Banca d’Italia (2019), Provvedimento sanzionatorio n.144 7.3.2019;

iii) Borzi N. (2019), “Il software Gianos e le falle nel sistema antiriciclaggio UBI”;

iv) BCBS (2013), “risk data aggregation and reporting”, paper 239;

v) Pierpaolo Fratangelo, Maria Pia Peluso, Banca d´Italia, Le nuove norme antiriciclaggio: i presidi aziendali alla prova del rischio di riciclaggio. Bancaria Editrice 3-2019;

vi) Marco Stellin, La nuova sfida della funzione antiriciclaggio: il collegamento fra rischio di riciclaggio e Risk Appetite Framework;

vii) Luciano Murtas, Intermediari assicurativi di fronte a nuovi adempimenti antiriciclaggio (Diritto24.it);

Siti web consultati:

https://valori.it/il-softaaware-gianos-e-le-falle-nel-sistema-antiriciclaggio-ubi/

http://www.ilgiornale.it/news/ecco-funziona-gianos-sentinella-dell-antiriciclaggio.html

https://www.repubblica.it/economia/2019/03/16/news/ing_stop_operazioni_bankitalia-221756978/

[1] Cfr. per tutti: https://www.repubblica.it/economia/2019/03/16/news/ing_stop_operazioni_bankitalia-221756978/

[2] Cfr. Per tutti: https://valori.it/il-software-gianos-e-le-falle-nel-sistema-antiriciclaggio-ubi/

[3] Lo studio della UIF pubblicato sulla pagina web: http://uif.bancaditalia.it/pubblicazioni/quaderni/2019/quaderno-12-2019/Effetto_ispezioni_estratto_in_italiano_web.pdf utilizza i dati delle ispezioni antiriciclaggio svolte dalla Vigilanza e dalla UIF nel biennio 2012-2013, incrociati con i flussi di segnalazioni di operazioni sospette trasmessi dalle singole banche (ispezionate e non) e con le statistiche sull’attività operativa degli intermediari fornite dai dati antiriciclaggio ‘aggregati’ (SARA).

[4] I fattori che vengono presi in considerazione per la determinazione di una c.d. operazione anomala (che dovrà poi essere evidenziata alla banca) fanno riferimento, tra le altre cose, ai comportamenti enucleati all´interno dei singoli schemi di anomalia pubblicati tempo per tempo dalla UIF nonché al Provvedimento n. 616 del 24 agosto 2010 emanato dalla Banca d`Italia.

[5] Che certamente deve essere corroborata da un ragionamento complesso e deve dar luogo ad un´analisi approfondita che unisca tutti i necessari elementi soggettivi e oggettivi.

[6] “Le nuove tecnologie possono rendere più efficienti ed efficaci i controlli tanto nella fase di acquisizione del cliente che in quella di monitoraggio. Strumenti di controllo biometrico, tecniche di elaborazione massiva dei dati o sistemi di intelligenza artificiale possono, infatti, garantire una piú estesa capacità di captazione delle informazioni rilevanti, ma anche una migliore reattività agli stimoli che possono derivare dalla valutazione di queste attività” (cfr. Pierpaolo Fratangelo, Maria Pia Peluso in Le nuove norme antiriciclaggio: i presidi aziendali alla prova del rischio di riciclaggio. Bancaria editrice 3/2019)